Одной из важных составляющих при успешном продвижении сайта есть внутренняя оптимизация. Очень часто у сайтов присутствуют проблемы в дублированием страниц, из-за чего результаты продвижения могут быть низкими.

В этой статье мы расскажем про самые частые и основные виды дублирования и методы их устранения.

Виды дублирования контента

1. Полное дублирование

Полное дублирование — одна и та же страница доступна по разным URL. Оптимальное решение проблемы полного дублирования — 301 редирект со страниц дублей на канонические страницы.

Когда возникает полное дублирование:

1.1 URL с GET парамметрами

site.com/index.php?cat=10&product=25

По сути, это та же страница, что и

site.com/index.php?product=25&cat=10

Решение проблемы: необходимо настроить ЧПУ, и 301 редирект со старых URL с get-параметром на новые ЧПУ.

1.2 Неправильно настроена страница 404 ошибки

Иногда в индекс попадают дубли страниц из-за неправильной настройки страницы 404 ошибки.

Пример 1:

Каноническая страница http://site.com.ua/produktsiya/primer/ и ее дубли:

http://site.com.ua/produktsiya/primer/,,,,,

http://site.com.ua/produktsiya/primer/555

Пример 2:

http://site.ru/catalog/winter-clothing/working-suits.html

http://site.ru/catalog/working-suits.html

Пример 3: адреса с index.php, index.html, index.htm, default.asp, default.aspx

- https://www.rooms.hp.com/attend/default.aspx

https://www.rooms.hp.com/attend/ - https://www.rooms.hp.com/default.aspx

https://www.rooms.hp.com/ - http://vipip.ru/index.php

http://vipip.ru/ - http://www.colby.edu/~bknelson/SLC/index.php

http://www.colby.edu/~bknelson/SLC/ - http://www.nasa.gov/multimedia/index.html

http://www.nasa.gov/multimedia/

Решение проблемы — необходимо настроить 301 редирект на канонические страницы, или отдавать страницу 404 ошибки при запросе неканонического URL. Каждая страница сайта должна быть доступной только по одному URL.

1.3. URL в разных регистрах

Довольно часто встречается явление, когда одна и та же страница доступна по URL в разных регистрах:

http://avtobazakiev.com/cars/chrysler/

http://avtobazakiev.com/CARS/chrysler/

Решение проблемы — необходимо настроить 301 редирект с URL в верхнем регистре на URL в нижнем (или наоборот), или отдавать 404 страницу при запросе не канонического URL.

1.4. Адреса с “/” и без в конце УРЛ

http://avtobazakiev.com/cars/chrysler/

http://avtobazakiev.com/cars/chrysler

Решение проблемы — необходимо настроить 301 с неканонических URL на канонические URL, или отдавать 404 страницу при запросе не канонического URL.

1.5. Первая страница пагинации

В большинстве интернет-магазинов первая страница пагинации и страница категории имеют разные адреса и одинаковое содержания.

Пример:

http://avtobazakiev.com/cars/chrysler/?pageID=1

http://avtobazakiev.com/cars/chrysler/

Решение проблемы — необходимо настроить 301 с первой страницы пагинации на страницу категории.

1.6. 302 редирект

Если со страницы с дублированным контентом стоит 302 редирект страница не выпадет из индекса.

Решение проблемы — необходимо настроить 301 редирект.

2. Частичное дублирование — на разных страница дублируется блок контента.

Когда возникает частичное дублирование

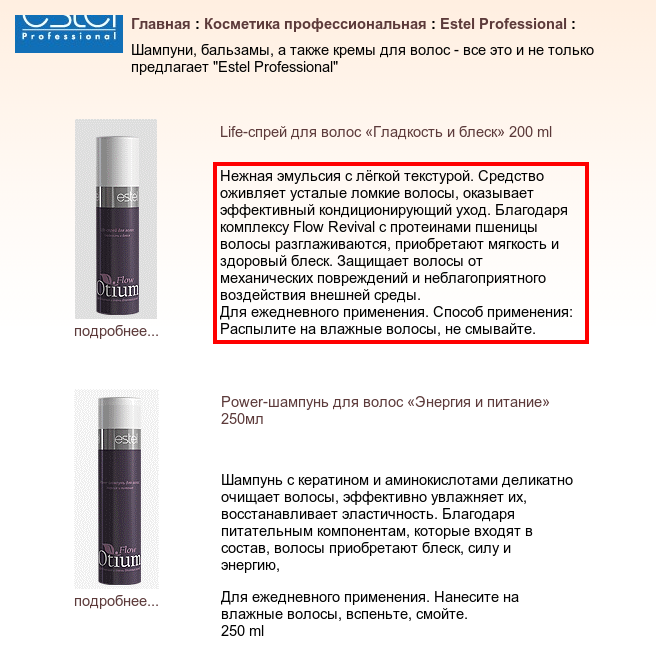

2.1 Дублирование описания товара/страницы на страницах каталогов (категорий). На страницах категорий часто выводят краткое/полное описание товара, которое дублирует описание на странице категории.

Страница каталога:

Страница товара:

Варианты решения проблемы:

-

Не выводить описание на странице каталога

-

Выводить уникальное описание, которое не будет дублироваться на странице товара (Возможный вариант — создать шаблон формирования краткого описания товара из характеристик товаров)

-

На странице категории выводить описание через iFrame или Ajax. Таким образом описание не будет доступно роботам поисковых систем.

2.2. Дублирование контента на страницах сортировок, пагинаций, фильтраций. Страницы сортировок, фильтраций имеют похожее содержание (изменяется только порядок вывода элементов).

Решение проблемы:

-

на всех страницах пагинаций, фильтраций, сортировок выводить тег <link href=»канонический» rel=»canonical» /> с указанием канонической страницы (категории)

-

на всех страницах пагинаций, фильтраций, сортировок выводить мета-тег <meta name=»robots» content=»noindex» />

Основные методы поиска полных дублей на сайте

Ниже описаны основные методы, с помощью которых можно быстро найти дубли страниц своего сайта. Используйте их периодически.

1. Поиск дублей через Google Webmasters Tools

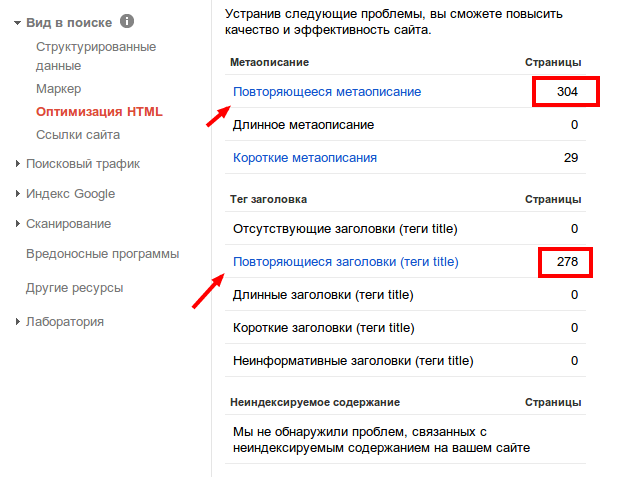

Зайдите в панель Google для вебмастеров. Найдите раздел меню «Вид в поиске» – «Оптимизация HTML». На этой странице можно увидеть количество страниц с повторяющимся Title и Description.

Таким способом можно найти полные копии страниц. Этот метод подходит для поисков дублей контента на старых, проиндексированных в ПС Google сайтах.

2. Программа Xenu

Xenu Link Sleuth — одна из популярных программ среди оптимизаторов, которая помогает проводить технический аудит сайта и, в том числе, находить дублирующиеся заголовки (если, например, у вас нет доступа к Google Webmasters Tools или сайт не проиндексирован).

Просканируйте сайт, отсортируйте результаты по заголовку (Title) и ищите совпадения заголовков. При всем удобстве, данный способ имеет тот же недостаток — нет возможности найти частичные дубли страниц.

3. Анализ страниц в индексе Google

Для поиска дублей в Google можно воспользоваться запросом.

site:mysite.com

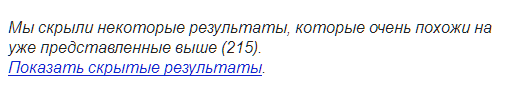

Далее пролистать странички выдачи до тех пор, пока не встретите подобную надпись.

Перейдя по ссылке и снова пролистав эти странички увидим результаты второстепенного индекса, т.е. страницы, которые по мнению ПС имеют низкое качество, зачастую это страницы с дублирующимся контентом.

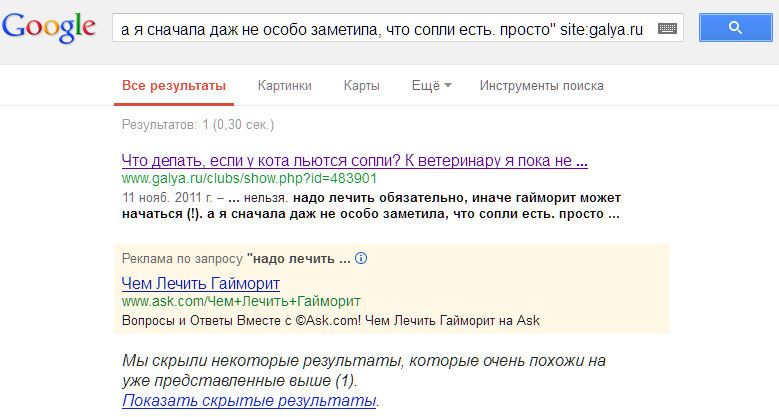

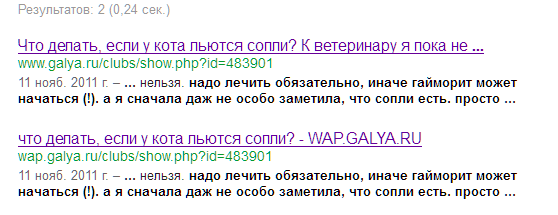

4. Поиск в Google по точному вхождению фрагмента текста

Выполните в Google запрос:

“<фрагмент текста со страницы>” site:yoursite.com

Перейдите по ссылке «показать скрытые результаты»

и вы увидите страницы с дублированием контента.

Таким образом с помощью предложенных инструментов и методов Вы с легкостью сможете найти дубли и проблемы на Вашем сайте. Устраняйте дублирование контента и продвижение Вашего сайта будет эффективным и результативным.