Если у Вашего сайта есть параметры URL-адресов, создающие потенциальные проблемы с дублированным контентом, попробуйте новую опцию URL Parameters в Google Webmaster Tools.

Функции Parameter Handling (Обработка параметров) больше нет по адресу Site configuration > Settings section в Webmaster Tools. Ничего страшного, ее просто переименовали в URL Parametrs (Параметры URL) и добавили ей новые функции. Конфигурация URL параметров, сделанная с учетом функций старой версии, будет автоматически отображаться в новой.

Прежде, чем рассказать все интересное, что можно сделать с помощью Параметров URL, давайте вспомним, зачем нужна эта опция.

Когда нужно использовать URL Параметры

Параметры URL помогут вам контролировать, какие адреса на Вашем сайте должны сканироваться Googlebot, в зависимости от параметров этих адресов. Это хороший способ запретить сканирование дублированного контента на вашем сайте.

Однако эту функцию нужно использовать, только если вы уверены в параметрах URL вашего сайта. Иначе можно по ошибке закрыть некоторые адреса для индексации, сделав контент невидимым для робота.

Новинки

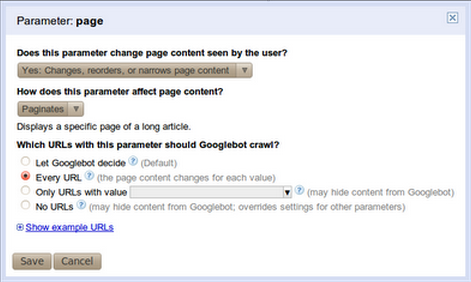

В дополнение к указанию действий по индексации отдельного параметра, теперь можно описать и его поведение. Можно указать — изменяет ли параметр содержимое страницы. Если не изменяет, робот будет выбирать адреса с типичным значением для этого параметра и индексировать их.

Если параметр не изменяет содержание, любое выбранное значение одинаково хорошо. Но если он изменяет содержание страницы, можно указать роботу один из четырех возможных способов сканирования с этим параметром:

- Let Googlebot decide (решает робот)

- Every URL (каждый адрес)

- Only crawl URLs with value=x (сканировать только адрес со значением х)

- No URLs

Также есть возможность добавлять собственные значения, которые будут использоваться с третьим вариантом; то есть, больше нет ограничения по стандартному списку значений. По желанию можно указать задачи параметра: сортировка, нумерация страниц, определение содержимого.

Одно из последних улучшений — отображение (как пример) адреса сайта, просканированного роботом, содержащего конкретный параметр.

Из четырех вариантов сканирования, перечисленных выше, No URL — новый, и заслуживает особого внимания. Этот вариант имеет самые большие ограничения и приоритет по настройкам параметров для любого заданного URL.

Это значит, что если адрес содержит параметр, установленный в «No URL», он никогда не будет сканироваться, даже если другие параметры установлены на Every URL. Вторым по ограничениям является Only crawl URLs with value=x.

Использование функции

На примерах.

Когда-то давно существовал магазин fairyclothes.example.com. Сайт магазина использовал параметры в своих адресах, и то же самое содержание был доступно через несколько URL-адресов.

Однажды владелец магазина заметил, что избыток адресов может мешать роботу полностью просканировать сайт. Поэтому он послал своего помощника, Любителя Задавать Вопросы (ЛЗВ) к Великому Сетевому Волшебнику (ВСВ) за консультацией, как заставить робота как можно меньше сканировать дублированный контент.

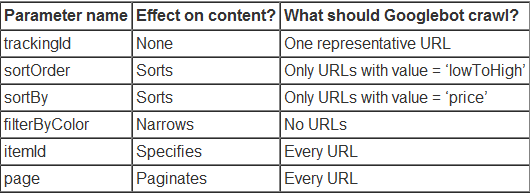

Волшебник предложил ему такую конфигурацию:

Любитель, по своей природе, начал задавать вопросы:

ЛЗВ: Вы дали указание роботу выбирать образец URL для trackingId (значение, которое будет выбрано роботом). Почему не выбрать опцию Only URLs with value=x и определить значение самостоятельно?

ВСВ: во время индексации робот Google натолкнулся на следующие URL, связанные с вашим сайтом:

1. fairyclothes.example.com/skirts/?trackingId=aaa123

2. fairyclothes.example.com/skirts/?trackingId=aaa124

3. fairyclothes.example.com/trousers/?trackingId=aaa125

Представьте, что нужно сказать роботу Google сканировать только по адресу «trackingId=aaa125». Тогда робот не просканировал бы URL 1 и 2, потому что у них нет значения aaa125 для trackingId. Их содержание не попало бы в индекс, и ни одна из прекрасных юбок (ассортимент магазина) не обнаружилась бы в результатах поиска Google.

Нет, в этом случае лучше выбрать образец URL. Почему? Это говорит роботу, что, когда он натыкается в сети на два URL, отличающихся по этому параметру (как адреса 1 и 2 выше), то ему нужно просканировать один из них, и он все равно получит все содержание.

В приведенном выше примере будут просканированы два URL, или 1 и 3, или 2 и 3. Ни одна юбка или брюки не потеряются.

ЛЗВ: а как насчет параметра sortOrder? Мне все равно, если элементы перечислены в порядке возрастания или убывания. Почему не дать Google выбрать представленное значение?

ВСВ: В то время как Googlebot продолжает сканировать, он может найти следующие URL:

1. fairyclothes.example.com/skirts/?page=1&sortBy=price&sortOrder=’lowToHigh’

2. fairyclothes.example.com/skirts/?page=1&sortBy=price&sortOrder=’highToLow’

3. fairyclothes.example.com/skirts/?page=2&sortBy=price&sortOrder=’lowToHigh’

4. fairyclothes.example.com/skirts/?page=2&sortBy=price&sortOrder=’ highToLow’

Обратите внимание: первая пара адресов (1 и 2) отличается только значением параметра sortOrder, по отношению ко второй паре (3 и 4). Однако, URL-адреса будут отображать разное содержание: первый покажет самую дешевую юбку, а второй — самую дорогую.

Использование единственного образцового значения — не лучший выбор в вашей ситуации. Кроме того, если вы позволите выбрать Google выбрать один образец из набора URL-адресов, которые отличаются только по sortOrder, он сможет каждый раз выбирать другое значение.

В примере выше, от первой пары URL может быть выбран URL-1 (sortOrder =»lowToHigh»). Принимая во внимание, что от второй пары может быть выбран 4-й. (sortOrder =»highToLow»).Если бы так случилось, Google просканировал бы менее дорогие юбки два раза:

fairyclothes.example.com/skirts/?page=1&sortBy=price&sortOrder=’lowToHigh’

fairyclothes.example.com/skirts/?page=2&sortBy=price&sortOrder=’ highToLow’

А дорогие юбки не сканировались бы вообще! При работе с сортировкой последовательность параметров является ключевой. Всегда сортируйте так же.

ЛЗВ: что насчет ценности значения sortBy?

ВСВ: Это очень похоже на sortOrder. Вы хотите, чтобы просканированные адреса вашего списка были последовательно отсортированы по всем страницам, иначе робот не увидит некоторые элементы.

Однако нужно осторожно выбирать значения. Если вы продаете книги так же, как и обувь в вашем магазине, лучше не выбирать значение title, потому что адреса, указывающие на обувь, никогда не содержат sortBy=title и, таким образом, они не просканируются.

Аналогично настройки sortBy=size хорошо работают для сканирования обуви, но не для книг. Конфигурация параметров влияет на весь сайт.

ЛЗВ: Почему не сканировать адреса с помощью параметра filterByColor?

ВСВ: Представьте, что у вас есть список юбок на три страницы. Одни юбки синие, вторые красные, третьи — зеленые.

fairyclothes.example.com/skirts/?page=1

fairyclothes.example.com/skirts/?page=2

fairyclothes.example.com/skirts/?page=3

Это список фильтрации. Когда пользователь выбирает цвет, он получает две страницы с синими юбками:

fairyclothes.example.com/skirts/?page=1&flterByColor=blue

fairyclothes.example.com/skirts/?page=2&flterByColor=blue

Они выглядят как новые страницы (набор элементов не такой, как на других страницах), но в действительности на них не будет ничего нового, потому что все синие юбки уже включены в три оригинальные страницы.

Не нужно сканировать адреса, которые сужают контент по цвету, потому что поданный по ним контент уже сканировался. Еще одно важное замечание: прежде, чем запретить некоторые адреса к индексации, выбрав No URL, убедитесь, что робот сможет получить доступ к контенту другим способом.

Учитывая наш пример, робот должен найти три первые ссылки на вашем сайте и не должно быть никаких настроек, затрудняющих индексацию.

По материалам googlewebmastercentral.blogspot.com.